Alibaba greift Google & OpenAI an: Das ist Qwen2.5-Omni, die Open-Source-KI, die sieht, hört und spricht

Im Wettrennen um Künstliche Intelligenz (KI) gibt es einen neuen Mitspieler. Google’s Gemini und OpenAI beeindrucken uns mit ihren Fähigkeiten, Bilder, Videos und Ton neben Text zu verstehen. Aber das Qwen-Team von Alibaba hat jetzt etwas vorgestellt, das alles verändern könnte: Qwen2.5-Omni. Das ist nicht einfach nur ein weiteres großes Sprachmodell. Es ist eine "omnidirektionale" KI, die die Welt so wahrnehmen soll, wie wir. Sie verarbeitet Text, Bilder, Ton und Video und antwortet nicht nur mit Text, sondern auch mit gesprochener Sprache in Echtzeit.

Das vielleicht Wichtigste? Alibaba hat die Version mit 7 Milliarden Parametern, Qwen2.5-Omni-7B, als Open Source veröffentlicht. Sie steht unter der Apache 2.0 Lizenz. Das bedeutet, dass Entwickler und Firmen überall auf der Welt diese KI kostenlos nutzen können, auch für ihre Geschäfte. Das ist ein mutiger Schritt, der die geschlossenen Systeme der großen Konkurrenten herausfordert.

Was steckt dahinter? Die "Thinker-Talker"-Architektur

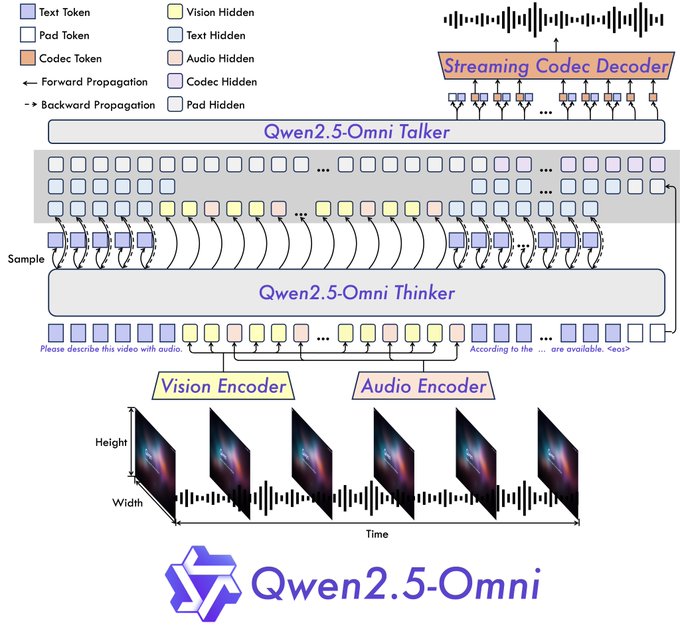

Alibaba hat nicht einfach nur ein paar Sinne an eine bestehende KI angehängt. Sie haben eine neue "Thinker-Talker"-Architektur entwickelt.

- Der Thinker (Denker): Dieser Teil ist wie das Gehirn. Er nimmt verschiedene Informationen auf – Text, Bilder, Töne – und verarbeitet sie. Er versteht den Zusammenhang und erstellt eine Art Zusammenfassung, zusammen mit der Antwort als Text. Er nutzt spezielle Encoder für Ton und Bild, um die wichtigsten Details herauszufiltern.

- Der Talker (Sprecher): Er ist wie Mund und Stimmbänder. Der Talker bekommt die Zusammenfassung und den Text vom Thinker in Echtzeit. Dann wandelt er das in einzelne Töne um und erzeugt so natürlich klingende Sprache, zusammen mit dem geschriebenen Text.

Diese Bauweise ist sehr wichtig, um Echtzeit-Gespräche zu ermöglichen. Die Architektur kann Informationen Stück für Stück verarbeiten und sofort ausgeben. So sollen sich Gespräche eher wie ein Videoanruf anfühlen als wie ein Chat, bei dem man abwechselnd schreibt.

Außerdem verwendet Qwen2.5-Omni eine neue Technik namens TMRoPE (Time-aligned Multimodal RoPE) für die Positionsbestimmung. Das löst ein schwieriges Problem: Videobilder und die passenden Tonspuren müssen genau gleichzeitig abgespielt werden. Das ist wichtig, um Aktionen und Sprache in einem Video richtig zu verstehen.

Was kann sie wirklich? Starke Sinne, aber nicht so schlau?

Alibaba sagt, dass Qwen2.5-Omni sehr gute Ergebnisse bei OmniBench erzielt. Das ist ein Test, der verschiedene Aufgaben mit Bild, Ton und Text kombiniert. Sie sagen auch, dass sie besser ist als ähnlich große Modelle, wie zum Beispiel Google's Gemini 1.5 Pro, und sogar besser als ihre eigenen Modelle, die nur für eine Sache gut sind (wie Qwen2.5-VL-7B für Bilder und Qwen2-Audio für Ton).

Die ersten Tests zeigen ein gemischtes Bild:

- Das Gute – Multitalent:

- Sehen: Sie hat in einem Überwachungsvideo "verdächtiges Verhalten" erkannt und richtig erklärt, warum.

- Video: Bei einem Tanzvideo hat sie genau beschrieben, was der Tänzer trägt, wie er sich bewegt und wo er ist.

- Hören: Sie hat die Schritte für ein Rezept (geschmortes Schweinefleisch) aus einer Tonaufnahme richtig zusammengefasst.

- Gespräche: Sie gibt gleichzeitig Text und natürlich klingende Sprache aus (auch wenn Englisch und Chinesisch gemischt sind). Das geht schnell und flüssig und fühlt sich wie ein echtes Gespräch an. In den Demos sieht man Videoanrufe, in denen die KI die Umgebung beschreibt, als Assistent beim Kochen hilft, Song-Entwürfe beurteilt, Skizzen analysiert und sogar Matheaufgaben Schritt für Schritt anhand eines Fotos erklärt.

- Das Schlechte – Denkfehler und Probleme:

- Einfache Logikfehler: Obwohl sie so gut sehen, hören und sprechen kann, hat die 7B-Demoversion bei einfachen Aufgaben Probleme. Auf die Frage "Was ist größer, 6,9 oder 6,11?" hat sie falsch geantwortet, dass 6,9 kleiner ist. Auf die Frage, wie viele 'r's in "strawberry" sind, hat sie zwei gesagt (es sind drei). Das zeigt, dass es einen Unterschied zwischen dem, was sie wahrnehmen kann, und dem, was sie wirklich versteht, gibt.

- Braucht viel Leistung: Einige Nutzer, die das Modell auf ihrem eigenen Computer ausprobieren wollten, haben berichtet, dass es sehr viel Grafikspeicher (VRAM) benötigt. In einem Fall kam es zu einem Fehler, weil 100 GB VRAM für ein 21-Sekunden-Video nicht ausreichten. Andere haben Fehler bei größeren Bildern und lange Wartezeiten (Minuten pro Antwort) festgestellt. Das bedeutet, dass man das Modell optimieren oder spezielle Hardware verwenden muss, damit es gut funktioniert.

- Sprache & Anpassung: Englisch und Chinesisch funktionieren gut, aber andere Sprachen wie Spanisch und Französisch sind nicht so gut. Die Stimme gibt im Moment genau das wieder, was im Text steht. Mehr Möglichkeiten zur Anpassung wären gut für bestimmte Anwendungen. Auch die Bedienung für normale Nutzer könnte verbessert werden.

Open Source: KI für alle?

Die Entscheidung von Alibaba, Qwen2.5-Omni-7B als Open Source zu veröffentlichen, ist ein kluger Schachzug.

- Weniger Hürden: Startups, Forscher und sogar große Unternehmen können mit dieser KI experimentieren und sie nutzen, ohne teure Gebühren für die Nutzung oder Lizenzen zu zahlen. Das könnte Innovationen in folgenden Bereichen vorantreiben:

- Hilfsmittel für Menschen mit Behinderung: KI, die die Welt für Blinde beschreiben kann.

- Bildung: Interaktive Tutoren, die die Arbeit eines Schülers sehen und seine Fragen hören können.

- Kreative Unterstützung: Werkzeuge, die Kunst, Musik oder Texte anhand verschiedener Informationen beurteilen können.

- Intelligente Geräte: Natürlichere Bedienung von Wearables (wie intelligente Brillen) oder Sprachassistenten.

- Konkurrenzdruck: Dieser Schritt greift die Geschäftsmodelle von OpenAI und Google direkt an. Sie könnten gezwungen sein, ihre Preise zu überdenken oder günstigere Versionen ihrer Modelle anzubieten. Ein Nutzer nannte dies "echtes OpenAI", weil viele Entwickler sich starke, offene Werkzeuge wünschen.

- Aufbau eines Ökosystems: Für Alibaba könnte dies ein Weg sein, ein Netzwerk von Entwicklern rund um seine Qwen-Modelle aufzubauen. Das könnte die Nutzung fördern und die Nutzung seiner Cloud-Plattform, auf der das Modell ebenfalls gehostet wird, ankurbeln.

Fazit: Ein großer Schritt, aber die Reise geht weiter

Qwen2.5-Omni ist ein wichtiger Fortschritt im Bereich der KI. Besonders beeindruckend ist, wie gut sie verschiedene Informationen verarbeiten und in Echtzeit Text und Sprache ausgeben kann. Die Open-Source-Veröffentlichung des 7B-Modells ist ein großer Schritt, der die KI-Welt verändern könnte.

Die ersten Tests zeigen aber auch, dass gute Sinne nicht automatisch bedeuten, dass man fehlerfrei denken oder die KI einfach einsetzen kann. Die Logikfehler und der hohe Ressourcenbedarf zeigen, dass es noch Hürden zu überwinden gibt.

Für Unternehmen und Investoren ist Qwen2.5-Omni sowohl eine Chance als auch ein Anlass zur Beobachtung. Die Chance besteht darin, dieses leistungsstarke Werkzeug für Innovationen zu nutzen. Man sollte aber auch beobachten, wie sich das Modell weiterentwickelt, wie die Community die Probleme behebt und wie die Konkurrenten auf diese Open-Source-Herausforderung reagieren. Alibaba hat eine starke Karte gespielt; wir sind gespannt auf die nächsten Züge im spannenden Spiel der KI.

Quellen:

- Demo: https://huggingface.co/spaces/Qwen/Qwen2.5-Omni-7B-Demo

- Qwen Chat: https://chat.qwen.ai/

- GitHub: https://github.com/QwenLM/Qwen2.5-Omni

- Hugging Face Modell: https://huggingface.co/Qwen/Qwen2.5-Omni-7B

- Technischer Bericht: https://github.com/QwenLM/Qwen2.5-Omni/blob/main/assets/Qwen2.5_Omni.pdf

- Blog Post: https://qwenlm.github.io/blog/qwen2.5-omni/