Warum SlowFast-LLaVA-1.5 der Durchbruch für das Verständnis langer Videos sein könnte – ohne hohen Rechenaufwand

Der eigentliche Engpass bei der KI-Videoverarbeitung? Tokens, nicht nur Rechenleistung

Lange Videoinhalte boomen. Von Überwachungsvideos bis hin zu Bildungsvorträgen war die Notwendigkeit, Erkenntnisse aus mehrminütigen oder sogar mehrstündigen Videos zu gewinnen, noch nie so groß. Aber für KI ist das Verständnis des langfristigen zeitlichen Kontexts in Videos nicht nur eine Frage des Hinzufügens von mehr Frames oder der Feinabstimmung eines größeren Modells.

Die eigentliche Herausforderung? Token-Effizienz.

Die meisten bestehenden Video Large Language Models (Video-LLMs) haben Mühe, zu skalieren. Sie verarbeiten riesige Datenmengen, verbrauchen aber viel Rechenleistung und Speicher, was sie für mobile, Edge- oder sogar viele Enterprise-Bereitstellungen unpraktisch macht.

Hier kommt SlowFast-LLaVA-1.5 ins Spiel. Es wurde als token-effiziente, reproduzierbare Lösung für das Verständnis langer Videos entwickelt und kombiniert einen neuartigen Zwei-Stream-Verarbeitungsansatz mit einer schlanken Trainingspipeline – und liefert so eine hochmoderne Leistung auch mit kleineren Modellen (bis zu 1 Milliarde Parametern).

Für Unternehmen, die auf skalierbare KI setzen, und für Investoren, die nach Edge-basierten KI-Lösungen suchen, stellt dieses Modell eine bedeutende technische und strategische Verschiebung dar.

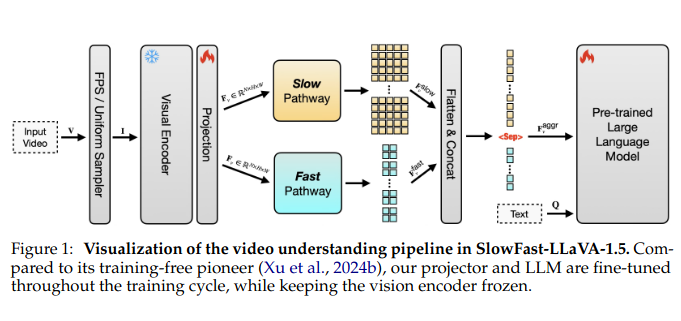

Die Zwei-Stream-Architektur, die das Spiel verändert hat

Im Kern von SlowFast-LLaVA-1.5 steckt ein cleverer architektonischer Kniff, der aus früheren Arbeiten zur Videoerkennung entlehnt und angepasst wurde: ein SlowFast-Mechanismus. So funktioniert es:

- Der Slow-Stream verarbeitet weniger Frames mit höherer Auflösung und erfasst so detaillierte räumliche Informationen aus ausgewählten Keyframes.

- Der Fast-Stream verarbeitet viel mehr Frames, aber mit geringerer Granularität, und konzentriert sich auf Bewegung und zeitlichen Fluss.

Durch die Kombination dieser Pfade und die Aggregation ihrer Ausgaben erfasst das Modell sowohl, was in jedem Frame passiert, als auch, wie sich Szenen im Laufe der Zeit entwickeln – ohne in Tokens zu ertrinken.

Dies ist eine Abkehr von monolithischen Videotransformatoren, die Schwierigkeiten haben, räumliche Genauigkeit und zeitliche Reichweite in Einklang zu bringen. Das Ergebnis? SlowFast-LLaVA-1.5 verarbeitet fast doppelt so viele Frames und verwendet dabei nur 65 % der Tokens im Vergleich zu anderen führenden Modellen.

Schlankeres Training, breitere Akzeptanz

Das Training großer Videomodelle ist notorisch aufwendig – oft unter Einbeziehung proprietärer Datensätze, mehrstufiger Pipelines und ressourcenintensiver Abstimmung. Die Autoren von SlowFast-LLaVA-1.5 wählten einen pragmatischeren Weg:

- Stufe I – Image-Only Fine-Tuning: Das Modell wird zuerst auf öffentlich zugänglichen Bilddatensätzen trainiert, um visuelle Grundlagen und allgemeines Denken zu etablieren.

- Stufe II – Gemeinsames Video-Image-Training: Anschließend wird es einem kuratierten Satz von Video- und Bilddaten ausgesetzt, wodurch das Modell sowohl räumliche als auch zeitliche Dynamiken erlernen kann.

Die Datensätze sind Open Source und der Ansatz ist reproduzierbar – zwei Attribute, die bei den jüngsten LLM-Releases oft fehlen. Diese Betonung der Zugänglichkeit ist nicht nur akademisch; sie senkt die Eintrittsbarriere für kleinere Unternehmen oder Startups, die fortschrittliche Video-KI integrieren möchten.

Benchmarks, die die Behauptung untermauern

Die Leistungskennzahlen wurden über mehrere hochkarätige Benchmarks hinweg getestet, darunter:

- LongVideoBench: 62,5 % mit dem 7B-Modell

- MLVU (Multimodal Long Video Understanding): 71,5 % mit demselben Modell

Bemerkenswerterweise lieferten selbst die 1B- und 3B-Parametermodelle wettbewerbsfähige Ergebnisse, was beweist, dass die Größe nicht immer das Unterscheidungsmerkmal ist. Das ist ein besonders attraktives Merkmal für Unternehmen, die mobile oder Edge-basierte Bereitstellungen untersuchen.

Darüber hinaus hat das Modell dank seiner gemeinsamen Trainingsstrategie die Bildverarbeitungsfähigkeiten nicht beeinträchtigt. Es konkurriert auf Augenhöhe mit dedizierten Bild-Sprach-Modellen – ein klarer Gewinn für die einheitliche multimodale Verarbeitung.

Effizienz ohne Kompromisse

In reinen Zahlen sind die Effizienzsteigerungen klar:

- Verarbeitet bis zu 2× die Anzahl der Frames

- Verwendet ~35 % weniger Tokens als vergleichbare Modelle

- Reduziert die Rechenkosten erheblich und hält gleichzeitig das Leistungsniveau oder übertrifft es sogar

Dieses Gleichgewicht zwischen Genauigkeit und Effizienz eröffnet ein breiteres Spektrum an Anwendungsfällen – von intelligenten Kameras und IoT-Überwachungssystemen bis hin zu In-App-Videoassistenten oder Enterprise-Knowledge-Mining-Tools.

Für Investoren bedeutet das eine höhere Kapitalrendite und geringere Markteintrittsbarrieren.

Strategischer Wert in allen Sektoren

Enterprise-KI-Integration: Mit seiner kompakten Größe und effizienten Architektur kann SlowFast-LLaVA-1.5 in Umgebungen eingesetzt werden, in denen Bandbreite, Rechenleistung und Latenz kritische Einschränkungen darstellen – denken Sie an Vor-Ort-Überwachung, Kundenverhaltensanalysen im Einzelhandel oder Maschinendiagnose vor Ort.

Medien- und Streaming-Plattformen: Die automatisierte Zusammenfassung, Suchindexierung und Inhaltsmoderation für lange Medieninhalte wird zu geringeren Kosten realisierbar.

Assistive Technologie & Barrierefreiheit: Die Echtzeitinterpretation von Videos für sehbehinderte Benutzer wird praktikabler, wenn die Verarbeitung keine Cloud-Scale-Infrastruktur erfordert.

Sicherheit & Verteidigung: Drohnen und On-Device-Überwachungssysteme profitieren immens von kleineren Modellen, die Live-Feeds analysieren können, ohne Gigabyte an Videos hochzuladen.

Einschränkungen und offene Möglichkeiten

Die Autoren räumen zwei Haupteinschränkungen ein:

- Frame-Sampling-Einschränkungen: Während das Frame-Sampling für die meisten Anwendungsfälle FPS-basiert ist, greift das Modell standardmäßig auf einheitliches Sampling zurück, wenn die Videolänge einen festgelegten Frame-Schwellenwert überschreitet – wodurch potenziell kritische Momente in ultralangen Inhalten verpasst werden.

- Frozen Vision Encoder: Um die Effizienz zu erhalten, bleibt der Vision Encoder während des Trainings eingefroren. Obwohl dies effektiv ist, kann die Feinabstimmung dieses Moduls eine höhere Leistung freisetzen, wenn auch zu höheren Rechenkosten.

Diese Einschränkungen weisen auf logische nächste Schritte für zukünftige Versionen hin: adaptive Sampling-Techniken, selektive Vision-Modulabstimmung und Integration von speichereffizienten Architekturen.

Warum das für die Branche wichtig ist

Das Vision-to-Language-Paradigma entwickelt sich schnell. Bisher basierten die meisten Durchbrüche im Bereich Video-KI auf roher Gewalt – größere Modelle, größere Datensätze, mehr Tokens.

SlowFast-LLaVA-1.5 bietet einen strategisch schlankeren Ansatz. Es ist nicht nur ein neues Modell – es ist ein Entwurf dafür, wie effiziente KI das Videoverständnis in verschiedenen Branchen skalieren kann, ohne die Infrastruktur zu überlasten.

Es zeigt, dass Token-Effizienz genauso leistungsfähig sein kann wie die Parameterskala – eine Botschaft, die sowohl die Forschungsgemeinschaft als auch das kommerzielle Ökosystem ernst nehmen müssen.

Abschließende Erkenntnisse für Investoren und Entwickler

Wenn Ihre Roadmap eine intelligente Videoverarbeitung beinhaltet – sei es für Consumer-Technologie, industrielle Anwendungen oder Echtzeitanalysen – ist SlowFast-LLaVA-1.5 ein Signal dafür, dass leistungsstarke KI nicht gleichbedeutend mit hohen Kosten sein muss.

Für Risikokapital öffnet dies die Tür zur Unterstützung von Startups, denen bisher die Ressourcen fehlten, um massive Videomodelle zu trainieren oder auszuführen. Für Enterprise-Entwickler ist es eine Chance, wettbewerbsfähige Video-KI einzusetzen, ohne Ihren gesamten Infrastruktur-Stack neu aufzubauen.